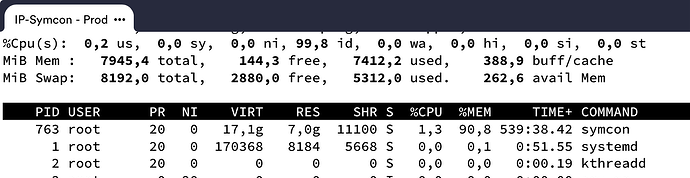

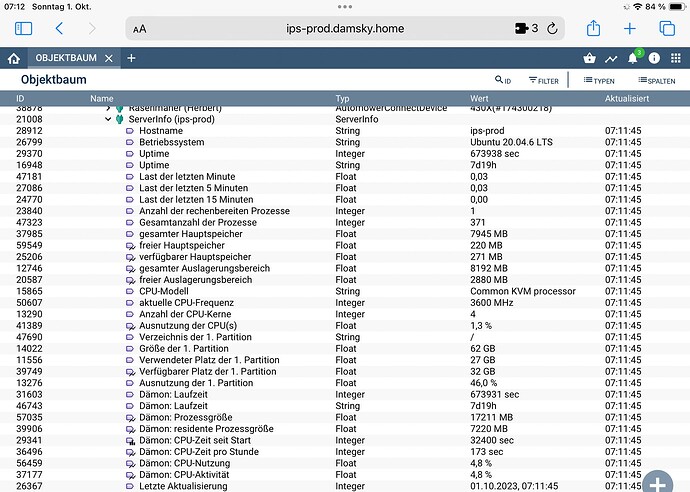

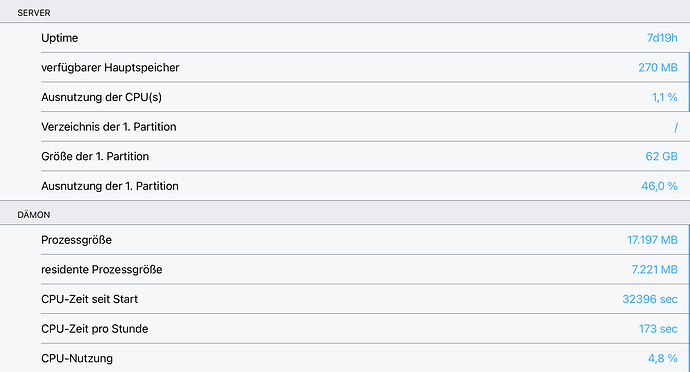

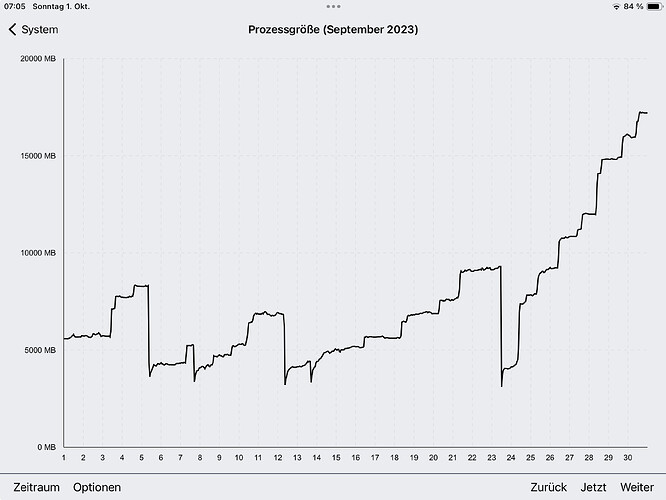

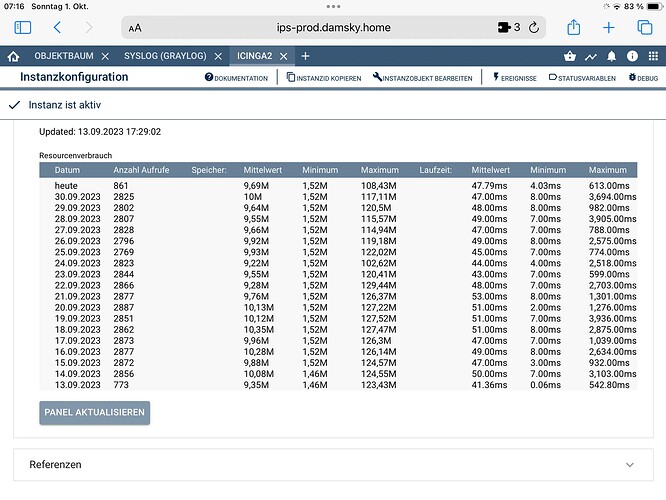

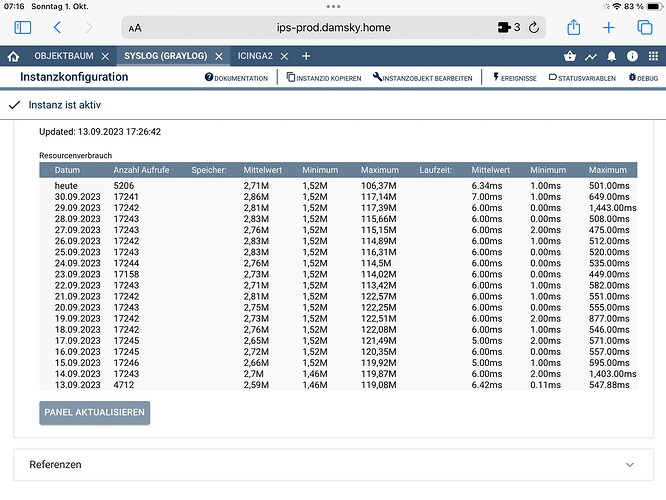

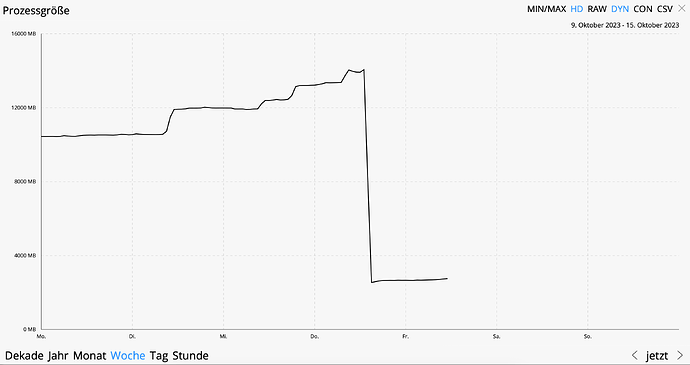

Eine Beobachtung: ich hatte letzte Tage ein IPS, das out of memory lief; nach 24h war der symcon-Prozess 5.2 GB groß, Tendenz weiter steigend.

Normalerweise liegt die Größe beim Start bei 2 GB und erhöht sich dann im Laufe einiger Stunden und liegt dann relativ stabil bei etwa 2.5-2.7 GB.

Das ist zwar auch nicht ohne, liegt aber auch daran, das ich ThreadCount = 100 gestellt und in der php.ini memory_limit=128M konfiguriert habe.

Der Hintergrund: ich hatte in einer Instanz den Debug in die Datei gelenkt und dieser Prozess war sehr geschwätzig (27 GB in 24h).

Nach IPS-Reboot war alles wieder tako.

Meine Version: IP-Symcon 6.4, Ubuntu (amd64), 23.05.2023, 6dccc096176c

Das recht hohe memory_limit habe ich übrigens, weil bestimmte Module sonst nicht durch laufen, zum einen meldet das Backup-Modul

Fatal error: Allowed memory size of 134217728 bytes exhausted (tried to allocate 20480 bytes) in /var/lib/symcon/modules/.store/de.symcon.backup/libs/vendor/phpseclib/phpseclib/phpseclib/Net/SFTP.php on line 3083

Die größte Datei ist die settings.json mit 13m.

Zum andern habe ich drei Module, die IPS_GetSnapshot() bzw IPS_GetSnapshotChanges() nutzen und häufiger mal an Memorygrenzen stossen (brauchen aber eigentlich nur ein Bruchteil des Snapshot).

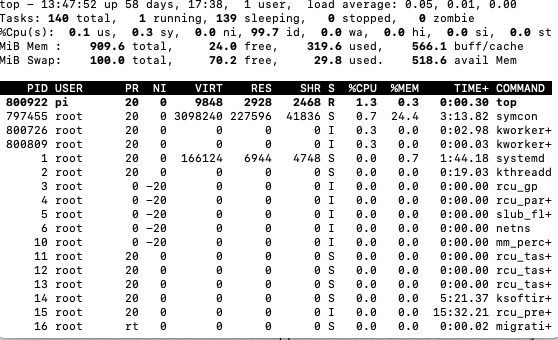

Nachtrag (26.9.2023)

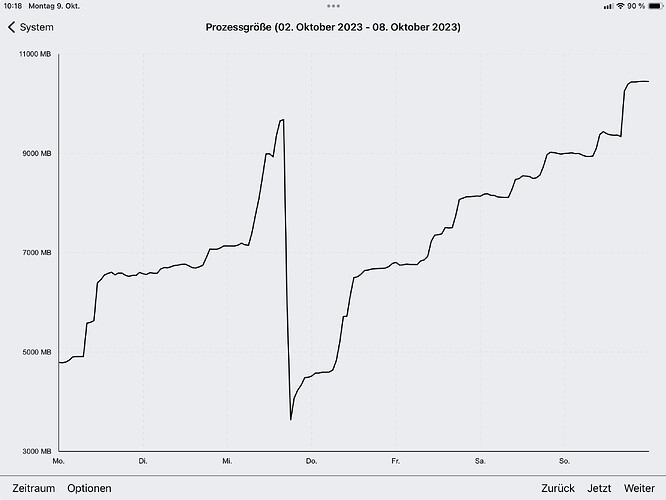

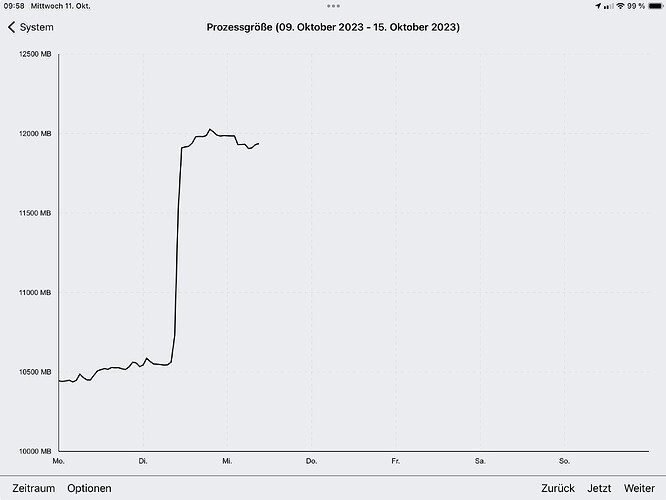

leider hat sich die Hoffnung zerschlagen, das ohne Logging in die Datei das System stabil bleibt. Ich musste gestern das IPS neu starten, weil das Memory komplett verbraucht war (5,6 GB für IPS), d.h. das IPS hat in einem knappen Monat zusätzlich 3 GB RAM belegt. Auch wenn es schnell geht - senden Monat das IPS zu geboten ist ja nicht erstrebenswert.

Die IPS-Verson ist unverändert (IP-Symcon 6.4, Ubuntu (amd64), 23.05.2023, 6dccc096176c).

Dieser Memoryverbrauch ist meiner Erinnerung nicht schon immer so gewesen.

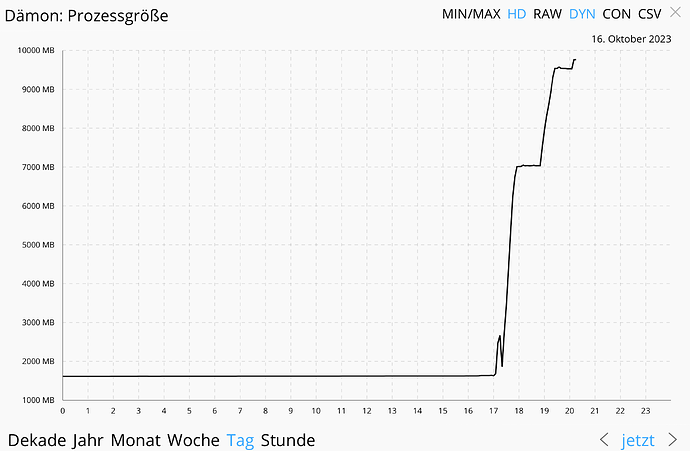

Ich kennen die Einbindung von PHP nicht, aber bin bisher davon ausgegangen, das der Speicher, den ein PHP-Thread benötigt, wieder freigegeben wird, wenn der Thread nicht mehr aktiv ist?

ThreadMemoryCleanup steht auf 10.

@paresy : gibt es irgend eine Möglichkeit, zu sehen, wo der Speicher verloren geht?